Το Ferret LLM της Apple θα μπορούσε να βοηθήσει στο Siri να κατανοήσει τη διάταξη των εφαρμογών σε μια οθόνη iPhone, αυξάνοντας ενδεχομένως τις δυνατότητες της ψηφιακού βοηθού της Apple.

Η Apple εργάζεται σε πολλά έργα μηχανικής μάθησης και τεχνητής νοημοσύνης που θα μπορούσε να παρουσιάσει για πρώτη φορά στο WWDC 2024. Σε ένα έγγραφο που μόλις κυκλοφόρησε, φαίνεται τώρα ότι ορισμένες από αυτές τις εργασίες έχουν τη δυνατότητα για τη Siri να κατανοήσει πώς μοιάζουν οι εφαρμογές και το ίδιο το iOS.

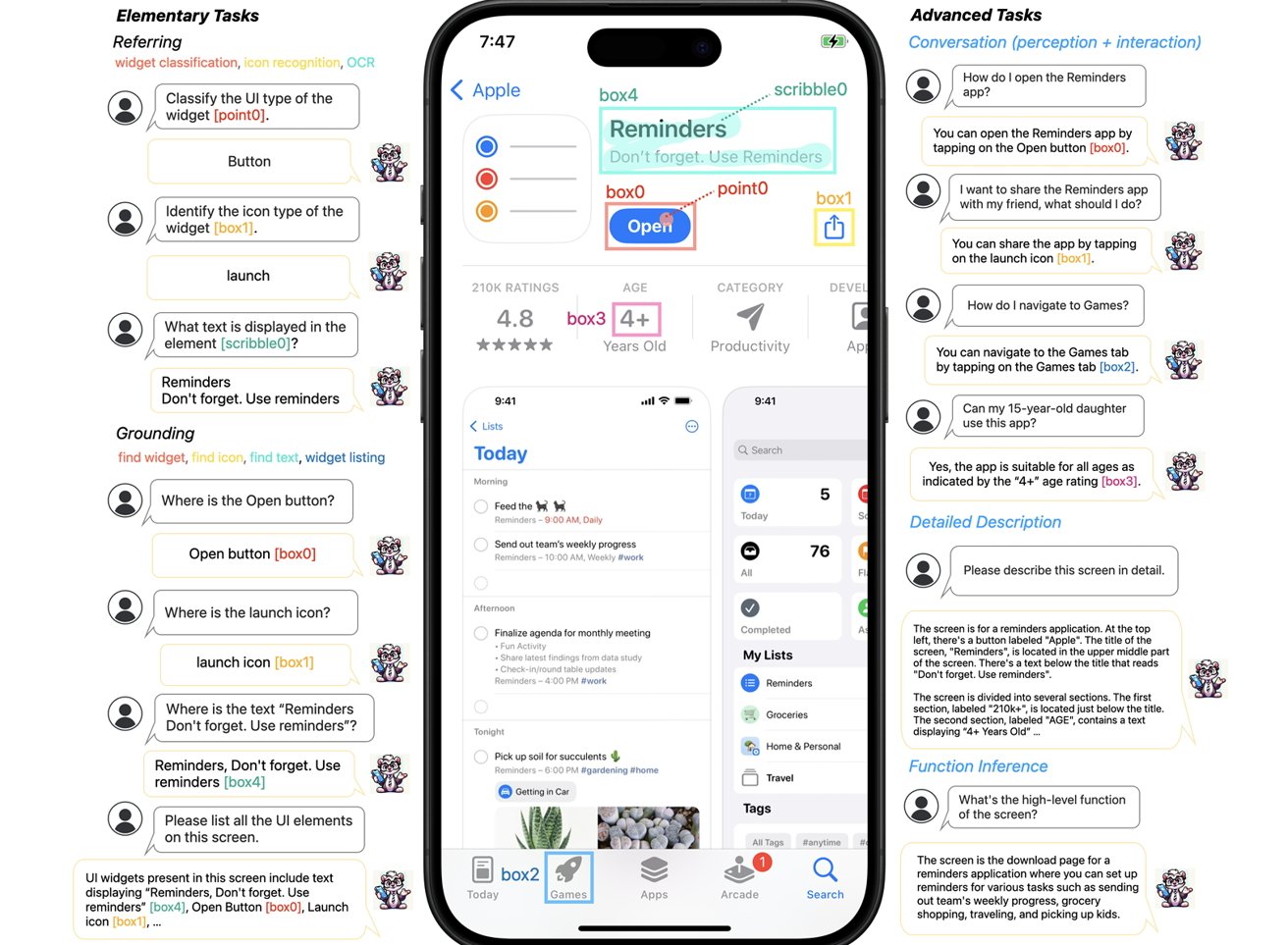

Η εργασία, που κυκλοφόρησε από το Πανεπιστήμιο Cornell τη Δευτέρα, έχει τον τίτλο “Ferret-UI: Grounded Mobile UI Understanding with Multimodal LLMs”. Ουσιαστικά εξηγεί ένα νέο πολυτροπικό μοντέλο μεγάλης γλώσσας (MLLM) που έχει τη δυνατότητα να κατανοεί τις διεπαφές χρήστη των οθονών που βρίσκονται σε mobile συσκευές.

Το όνομα Ferret προέκυψε αρχικά από ένα πολυτροπικό LLM ανοιχτού κώδικα που κυκλοφόρησε τον Οκτώβριο, από ερευνητές από το Πανεπιστήμιο Cornell που συνεργάζονται με ομολόγους της Apple. Εκείνη την εποχή, το Ferret ήταν σε θέση να ανιχνεύσει και να κατανοήσει διαφορετικές περιοχές μιας εικόνας για πολύπλοκα ερωτήματα, όπως η αναγνώριση ενός είδους ζώου σε ένα επιλεγμένο μέρος μιας φωτογραφίας.

Το νέο έγγραφο για το Ferret-UI εξηγεί ότι, ενώ έχουν σημειωθεί αξιοσημείωτες εξελίξεις στη χρήση του MLLM, εξακολουθούν να «υστερούν στην ικανότητά τους να κατανοούν και να αλληλεπιδρούν αποτελεσματικά με τις οθόνες διεπαφής χρήστη (UI).

Το Ferret-UI περιγράφεται ως ένα νέο MLLM προσαρμοσμένο για την κατανόηση των οθονών διεπαφής χρήστη για κινητά, με “δυνατότητες παραπομπής και συλλογισμού”.

Μέρος του προβλήματος που έχουν οι LLM στην κατανόηση της διεπαφής μιας οθόνης κινητής τηλεφωνίας είναι το πώς χρησιμοποιείται αρχικά. Συχνά σε κατακόρυφο προσανατολισμό, συχνά σημαίνει ότι τα εικονίδια και άλλες λεπτομέρειες μπορούν να καταλαμβάνουν ένα πολύ συμπαγές μέρος της οθόνης, καθιστώντας δύσκολη την κατανόηση για τις μηχανές. Για να βοηθήσει σε αυτό, το Ferret διαθέτει ένα σύστημα μεγέθυνσης για την αναβάθμιση των εικόνων σε “οποιαδήποτε ανάλυση” για να κάνει τα εικονίδια και το κείμενο πιο ευανάγνωστα.

Για επεξεργασία και εκπαίδευση, το Ferret χωρίζει επίσης την οθόνη σε δύο μικρότερα τμήματα, κόβοντας την οθόνη στη μέση. Το έγγραφο αναφέρει ότι άλλα LLM τείνουν να σαρώνουν μια καθολική εικόνα χαμηλότερης ανάλυσης, γεγονός που μειώνει την ικανότητα επαρκούς προσδιορισμού της εμφάνισης των εικονιδίων. Προσθέτοντας σημαντική επιμέλεια δεδομένων για εκπαίδευση, οδήγησε σε ένα μοντέλο που μπορεί να κατανοήσει επαρκώς τα ερωτήματα των χρηστών, να κατανοήσει τη φύση των διαφόρων στοιχείων στην οθόνη και να προσφέρει απαντήσεις με βάση τα συμφραζόμενα.

Αν και δεν γνωρίζουμε αν θα ενσωματωθεί σε συστήματα όπως η Siri, το Ferret-UI προσφέρει τη δυνατότητα προηγμένου ελέγχου σε μια συσκευή όπως ένα iPhone. Κατανοώντας τα στοιχεία της διεπαφής χρήστη, προσφέρει τη δυνατότητα της Siri να εκτελεί ενέργειες για χρήστες σε εφαρμογές, επιλέγοντας από μόνο του γραφικά στοιχεία εντός της εφαρμογής.

Υπάρχουν επίσης χρήσιμες εφαρμογές για άτομα με προβλήματα όρασης. Ένα τέτοιο LLM θα μπορούσε να είναι πιο ικανό να εξηγήσει λεπτομερώς τι υπάρχει στην οθόνη και ενδεχομένως να πραγματοποιήσει ενέργειες για τον χρήστη χωρίς να χρειάζεται να κάνει οτιδήποτε άλλο παρά να ζητήσει να συμβεί.

Aκολουθήστε το AppleWorldHellas στο Google News για να ενημερώνεστε άμεσα για όλα τα νέα άρθρα! Όσοι χρησιμοποιείτε υπηρεσία RSS (π.χ. Feedly), μπορείτε να προσθέσετε το AppleWorldHellas στη λίστα σας με αντιγραφή και επικόλληση της διεύθυνσης https://appleworldhellas.com/feed. Ακολουθήστε επίσης το AppleWorldHellas.com σε Facebook, Twitter, Instagram, και YouTube